Un estudio explora cómo los robots en el quirófano y como impactan en el trabajo en equipo de la sala de operaciones. Los investigadores de Cornell analizaron de cerca el impacto de ese cambio en un nuevo documento, “Operando a distancia: cómo un robot quirúrgico teleoperado reconfigura el trabajo en equipo en la sala de operaciones”, presentado en la Conferencia ACM sobre trabajo cooperativo y computación social con soporte informático Del 3 al 7 de noviembre en Jersey City, Nueva Jersey. En la cirugía tradicional, los médicos y las enfermeras se apiñan alrededor de un paciente, pasan los instrumentos, se observan las caras y, a menudo, se tocan físicamente. Durante la cirugía robótica, sin embargo, el robot está en el centro de la habitación. El cirujano está en un rincón, con la cabeza sumergida en una consola. El resto del personal médico está disperso, por lo general, no se pueden ver las caras y están desocupados por largos períodos de tiempo. «El robot influye en los aspectos del trabajo en equipo y tal vez dificulta el trabajo en equipo», dijo la autora principal Hannah RM Pelikan, ex becaria de Cornell en el laboratorio de Malte Jung , profesora asistente de ciencias de la información y coautora del

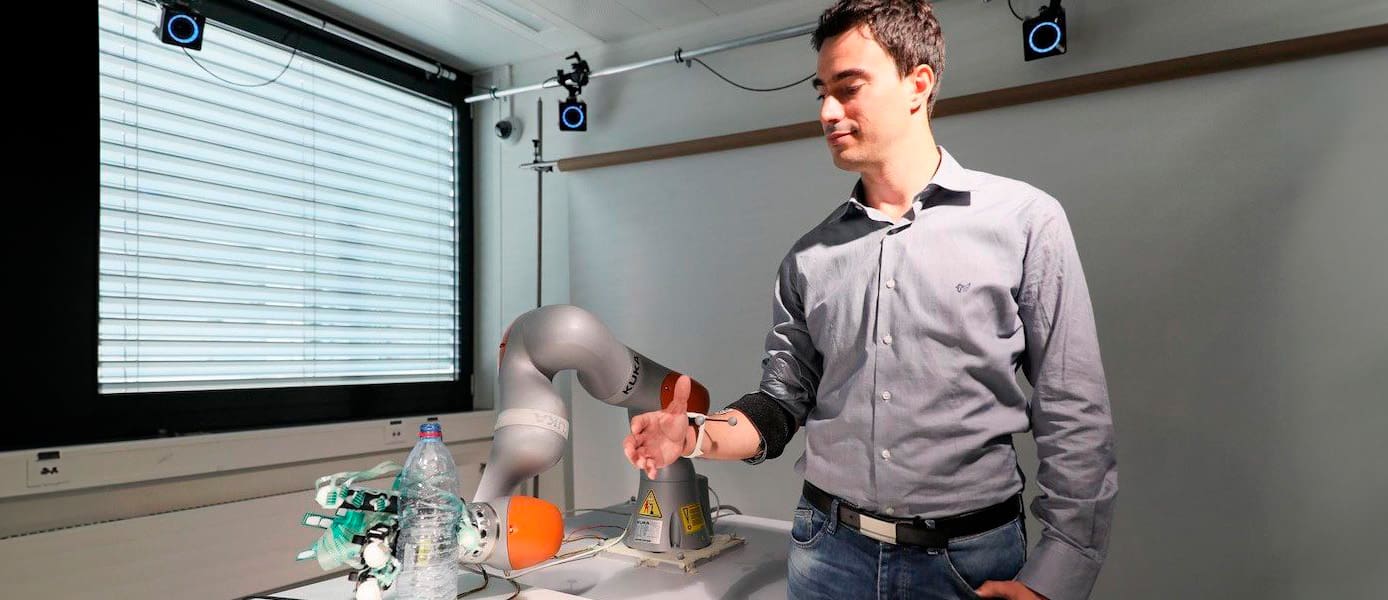

paper. «Definitivamente tienen que hacer más cosas para superar los desafíos que presenta el robot, y necesitan desarrollar nuevas estrategias». Los investigadores pasaron dos años entrevistando al personal médico y observando cirugías en dos hospitales de EE. UU. Utilizando el Sistema quirúrgico Da Vinci , un robot grande con varios brazos equipados con instrumentos quirúrgicos y una cámara endoscópica. El video grabó más de 50 horas de cirugías realizadas con y sin Da Vinci,

el robot quirúrgico más popular del mundo, controlado por el cirujano mediante un joystick y utilizado en 877,000 cirugías en 2017.

El Da Vinci ha sido acreditado con mayor precisión, mejor visión y reducción de la carga cognitiva y la fatiga física del cirujano, pero ningún estudio anterior examinó la distancia que crea dentro del equipo quirúrgico.

Los investigadores identificaron dos formas de distancia: cognitiva, con respecto a cómo el equipo colabora y se comunica; y afectivo, que se refiere a los sentimientos de desconexión emocional.

«Al entender que la dinámica social en equipos es realmente importante, me sorprendió la forma en que los ingenieros en ese contexto pensaban en la cirugía simplemente como la tarea mecánica de cortar y unir tejidos» —dijo Jung— «¿Qué sucede si tomas a un miembro crucial del equipo, a los líderes del equipo, y los metes en una caja?»

En la cirugía abierta (no robótica), los cirujanos a menudo usaban una sola palabra o señal con la mano para indicar lo que necesitaban, pero en la cirugía robótica, donde la mayoría de los miembros del equipo no se podían ver, era necesario decirlo en voz alta. Los miembros del equipo de cirugía robótica se comunicaron como pilotos de avión, dando instrucciones verbales y confirmándolos verbalmente. «Está presionando, ¿verdad?», Preguntó un cirujano en un momento, y el primer asistente respondió: «Presionando, señor», ambos reconociendo la pregunta e insertando el «señor» para indicar el final de la oración. En la cirugía abierta, los miembros del equipo operativo tendían a estar muy en sintonía con el estado de ánimo y las emociones de los demás, una necesidad cuando se realiza un trabajo tan complejo e intrincado. Pero el robot hizo más difícil medir los sentimientos, dijo Pelikan. «En la sala de operaciones realmente se vigilan mutuamente, realmente notan que si alguien no se siente bien, ven las cosas antes de que usted las diga», dijo Pelikan, quien planea comenzar un estudio de doctorado en la Universidad de Linköping en Suecia en noviembre. «Con el robot eso es más difícil». Los asistentes del cirujano se necesitaban con menos frecuencia en las cirugías robóticas, a veces llevándolos a conversar entre ellos o distraerse ocasionalmente. Esos chats también podrían causar un estrés leve para los cirujanos que escuchan las conversaciones que ocurren sin ellos.

Un cirujano le dijo a un entrevistador que se siente «solo» operando en la consola aparte de su equipo.Los equipos tendían a compensar este tipo de distancia afectiva en mayor o menor medida. Durante las cirugías abiertas, los cirujanos generalmente se fueron tan pronto como se completó la operación. Sin embargo, en las cirugías robóticas, los cirujanos a menudo se unían a los demás para lo que los investigadores denominaban un «grupo» después de los procedimientos, charlando, bromeando y, a veces, tocando.

«Ya podíamos comenzar a ver la incipiente generación de nuevos rituales quirúrgicos que se estaban inventando en respuesta a los tipos de desafíos que describimos», dijo Steven Jackson , profesor asociado de ciencias de la información, quien también es coautor del artículo, junto con Amy. Cheatle, estudiante de doctorado en ciencias y tecnología.